Luego de varias controversias sobre la versión inicial de chatGPT en donde , incluso, sus directivos y altos líderes salieron a declarar sobre la necesidad de ajustes sobre su primer versión, ahora han presentado el nuevo modelo de inteligencia artificial llamado Chat GPT-4.

La empresa organizó una transmisión en vivo para desarrolladores que mostró la primera demostración pública de ChatGPT-4 y nosotros estuvimos allí para contarte todos los detalles y la información más relevante!

Según los informes, el nuevo modelo de lenguaje grande (LLM) ha estado en desarrollo durante algunos años, y Microsoft confirmó que es la tecnología que impulsa el nuevo servicio Bing Chat de la compañía.

El presidente y cofundador de OpenAI, Greg Brockman, dirigió la presentación y analizó lo que GPT-4 es capaz de hacer, así como sus limitaciones. ¡Puedes ver una repetición del evento aquí!

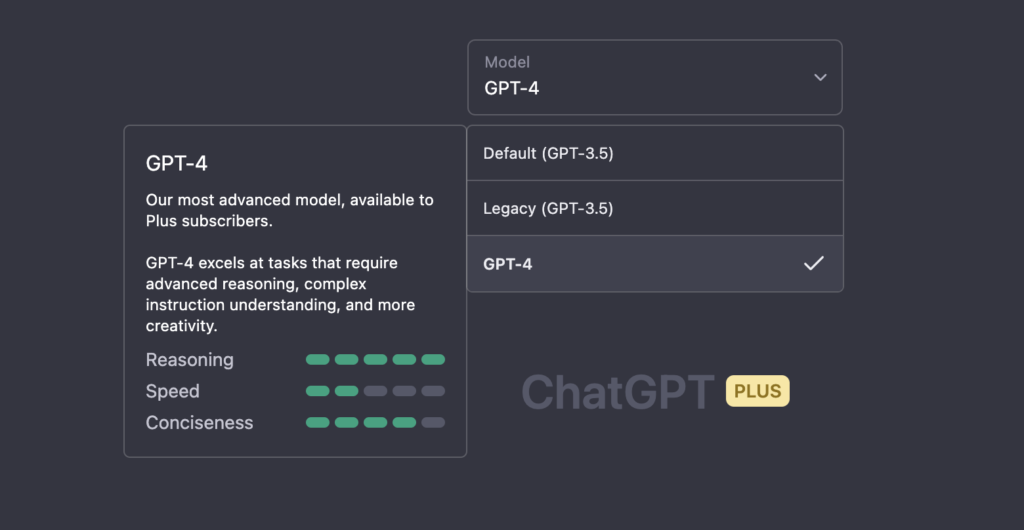

OpenAI ya ha anunciado que ChatGPT-4 solo estará disponible para los suscriptores de ChatGPT Plus.

Algunas mejoras de la versión 4 de ChatGPT

En nuestro equipo contamos con esta versión, y ya hemos notado rápidamente mejoras en la comunicación, que ya de por sí era muy buena. Uno de los aspectos que más nos llamó la atención es como el bot retomaba o tenía en cuenta la historia de nuestra comunicación, por ejemplo cuando le contamos que estabámos trabajando por la noche, y retomaba el tema más adelante por su propia cuenta.

Esta versión la estamos probando con una suscripción mensual de $20 USD. Cabe destacar que la versión gratuita de ChatGPT seguirá ejecutándose en el modelo GPT-3.5.

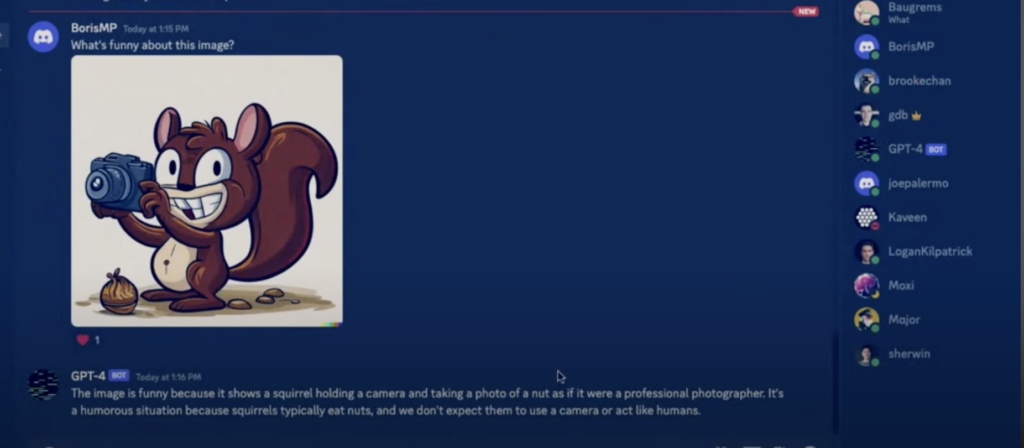

Reconocimiento de Imágenes en GPT-4

También en la demostración en vivo se pudo apreciar como el asistente virtual puede entender el concepto de una imagen determinada y cuando Greg mostró una imagen de Discord de una ardilla tomando una foto, el asistente pudo decirle porque esa imagen era graciosa y el motivo.

Es decir, el modelo 4 de ChatGTP puede interactuar con las personas mucho mejor que su predecesor.

La imagen la puedes ver en el video en el minuto 16:00, y fue enviada por un usuario asistente al evento en vivo.

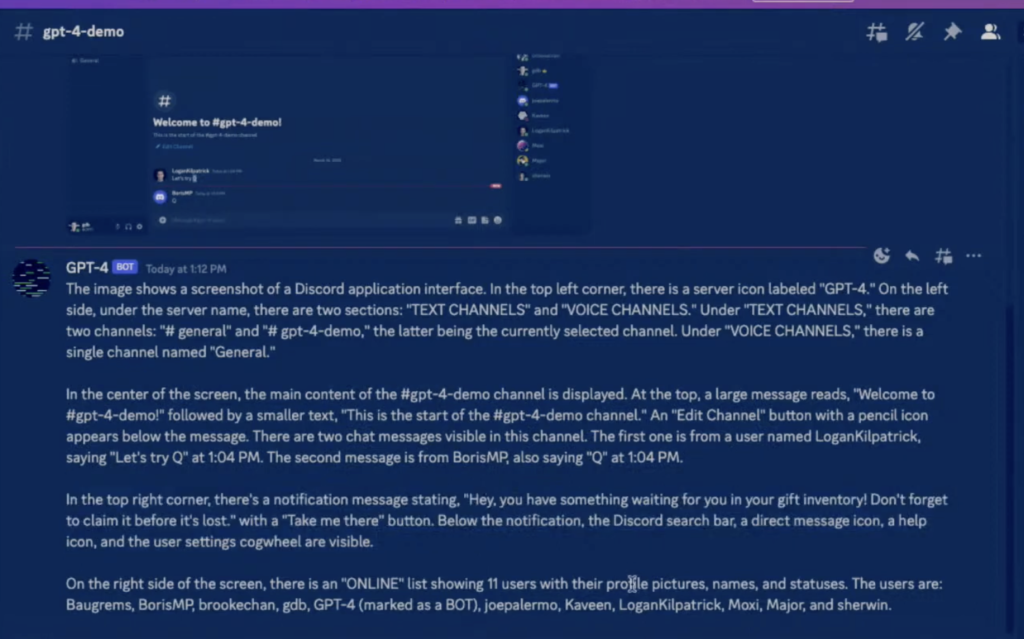

Descripción del contenido de una imagen con GPT-4

Otra funcionalidad que mostró resultados llamativos, fue la función de decodificar una imagen y describirla. Esto lo puedes ver en el minuto 12:00 del video. Como se observa Greg tomó una captura de Discord, y el bot realizó una descripción detallada de lo que se observa en cada sector de la imagen. Muy impresionante! Lejos ha quedado el tiempo donde los robots de los motores de búsqueda solo podían saber el contenido de una imagen por nuestra descripción en ella.

De hecho, OpenAI dice que ChatGPT-4 tampoco necesita texto. Puede recibir una imagen como aviso y generar una respuesta basada en ella. Cabe destacar que esta funcionalidad aun está en test, y no está disponible

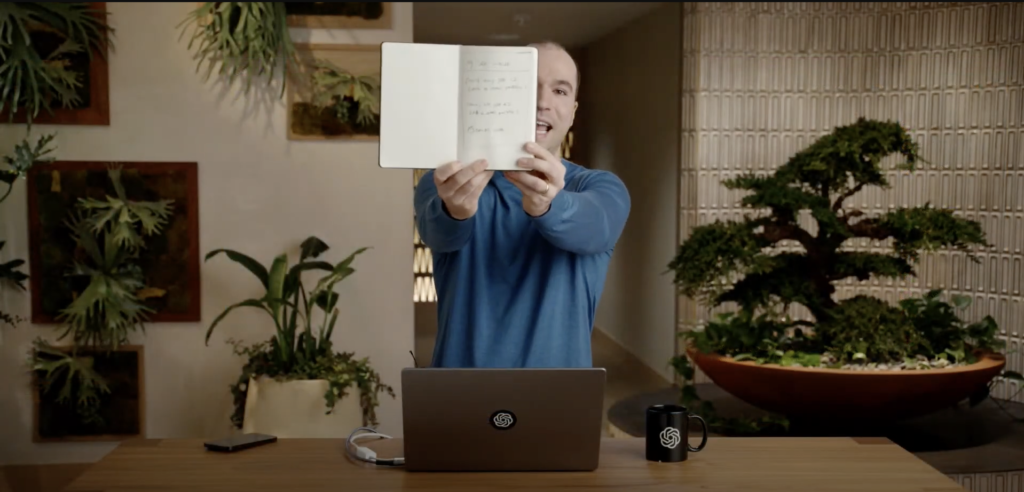

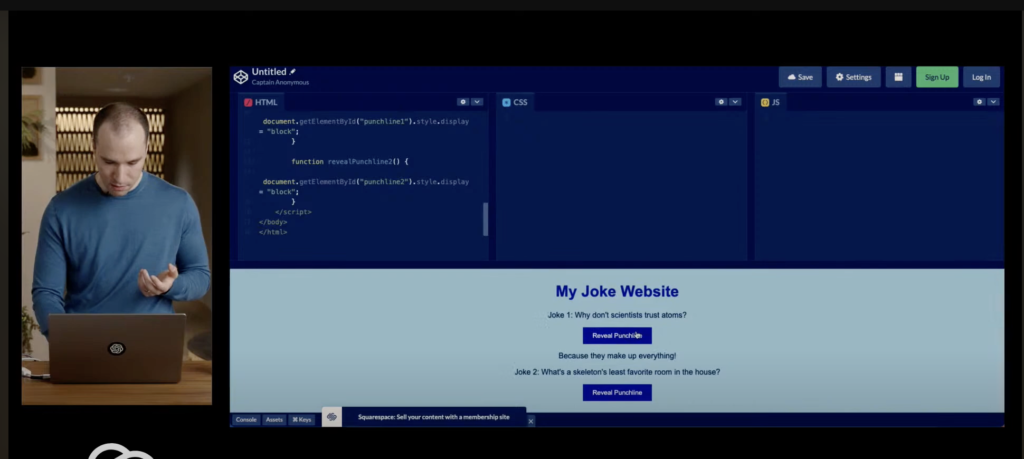

Generación automática de código a partir de un borrador a mano en GPT-4

La transmisión en vivo se centró en cómo los desarrolladores pueden aprovechar GPT-4 en sus propias aplicaciones de IA. Greg Brockman incluso mostró como el modelo 4 tiene la capacidad de interpretar texto y pasarlo a código (html,css,js).

Lo hizo a partir de un borrador hecho a mano, muy poco claro por cierto a nuestro gusto. Si fueramos los programador y el nuestro analista funcional o líder de proyecto, seguramente lo miraríamos con mala cara. Pero estos bots no tienen sentimientos!

Y no solo pudo entenderlo y no tratarlo como un jeroflífico, sino que además generó el código fuente HTML, css y JavaScript)

Personalmente, he visto desde los años 90 como los software intentaban crear código automatico sin mucho éxito, eran lentos, como un software de IBM que generaba código Java a partir de diagramas, (si alguna recuerda el nombre por favor comentelo aquí !). Los programadores ya verán qué utilidad le darán a este y otros generadores de código, pero seguramente poder pasar de un super borrador a una versión funcionado y editable de código bien generado en segundos, será seguramente una gran ayuda para programadores profesionales.

La presentación en vivo tuvo más de 100.000 asistentes y se espera que la semana próxima ya esté disponible para desarrolladores mientras que para el público en general podría usarse a partir de abril y solo quienes hayan pagado la versión plus.

ChatGPT y sesgos

Como dijimos al principio del artículo , hubo muchas controversias sobre la versión antecesora de ChatGPT debido a ciertos sesgos en los que ha incurrido el asistente a ciertas preguntas de los usuarios, incluso se ha podido observar cómo el comportamiento de la IA de OpenIA se vuelve errático y hasta desquiciado cuando entra en duda debido a su nula información de eventos recientes o posteriores a septiembre de 2021 que es la fecha hasta donde la IA ja guardado sus datos. En relación a esto OpenAI advierte que el nuevo modelo aún podría tener estos problemas, mostrando ocasionalmente “sesgos sociales, alucinaciones e indicaciones contradictorias”.

¿Has visto el evento? ¿Qué te ha parecido?

Deja un comentario